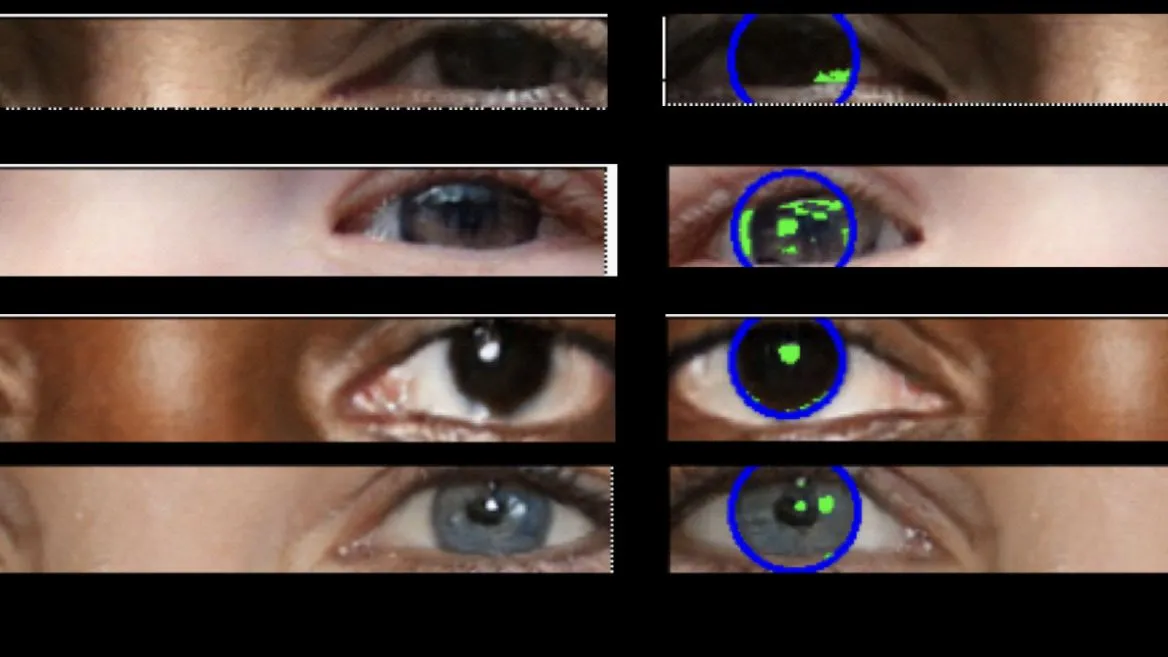

Eine Serie falscher Augen mit uneinheitlichen Spiegelungen in jedem Auge.(Bildnachweis: Adejumoke Owolabi)

Die Augen, so sagt ein altes Sprichwort, sind das Fenster zur Seele – aber wenn es um Deepfake-Bilder geht, könnten sie ein Fenster zur Unwirklichkeit sein.

Das geht aus neuen Forschungsergebnissen der Universität Hull in Großbritannien hervor. Dabei wurden Techniken angewandt, die normalerweise bei der Beobachtung ferner Galaxien zum Einsatz kommen, um festzustellen, ob Bilder von menschlichen Gesichtern echt sind oder nicht. Die Idee entstand, als Kevin Pimbblet, Professor für Astrophysik an der Universität, Gesichtsbilder untersuchte, die von den Künstliche-Intelligenz (KI)-Kunstgeneratoren Midjourney und Stable Diffusion erstellt wurden. Er fragte sich, ob er die Physik nutzen könnte, um zu bestimmen, welche Bilder gefälscht und welche echt sind. „Es dämmerte mir, dass die Reflexionen in den Augen das Naheliegendste sind“, sagte er gegenüber kosmischeweiten.de.

Deepfakes sind entweder gefälschte Bilder oder Videos von Menschen, die durch das Training von KI auf Bergen von Daten erstellt werden. Bei der Erstellung von Bildern eines menschlichen Gesichts nutzt die KI ihr umfangreiches Wissen, um Pixel für Pixel ein unwirkliches Gesicht zu erstellen; diese Gesichter können von Grund auf neu erstellt werden oder auf tatsächlichen Personen basieren. Im letzteren Fall werden sie oft für böswillige Zwecke verwendet. Da echte Fotos jedoch Spiegelungen enthalten, fügt die KI diese hinzu – allerdings gibt es oft subtile Unterschiede zwischen beiden Augen.

Mit dem Wunsch, seinem Instinkt zu folgen, rekrutierte Pimbblet Adejumoke Owolabi, eine Masterstudentin an der Universität, um bei der Entwicklung einer Software zu helfen, die schnell die Augen von Personen in verschiedenen Bildern scannen kann, um zu sehen, ob diese Spiegelungen in Ordnung sind. Die beiden entwickelten ein Programm, mit dem sie die Unterschiede zwischen dem linken und dem rechten Augapfel in Fotos von echten und unechten Personen bewerten konnten. Die echten Gesichter stammten aus einem vielfältigen Datensatz von 70 000 Gesichtern auf Flickr, während die Deepfakes von der KI erstellt wurden, die der Website This Person Does Not Exist zugrunde liegt, einer Website, die realistische Bilder von Personen erzeugt, von denen man annimmt, dass sie existieren, die es aber nicht tun.

Es ist offensichtlich, wenn man weiß, dass es da ist: Ich habe This Person Does Not Exist fünfmal aktualisiert und die Spiegelungen in den Augen studiert. Die Gesichter waren beeindruckend. Auf den ersten Blick gibt es nichts, was darauf hindeutet, dass sie gefälscht sind.

Fünf Bilder von Menschen aus ThisPersonDoesNotExist. (Bildnachweis: Adejumoke Owolabi)

Bei näherer Betrachtung wurden einige fast unmerkliche Unterschiede in der Beleuchtung der beiden Augäpfel festgestellt. Sie schienen nicht genau zueinander zu passen. In einem Fall erzeugte die KI einen Mann mit Brille – die Reflexion in seinem Brillenglas schien ebenfalls ein wenig abweichend zu sein.

Erhalten Sie den kosmischeweiten.de Newsletter

Was mein Auge jedoch nicht quantifizieren konnte, war, wie unterschiedlich die Reflexionen waren. Für eine solche Beurteilung braucht man ein Werkzeug, das Verstöße gegen die genauen Regeln der Optik erkennen kann. Hier kommt die Software Pimbblet und Owolabi ins Spiel. Sie verwendeten zwei Techniken aus dem Lehrbuch der Astronomie, die „CAS-Parameter“ und den „Gini-Index“.

In diesem Bild ist die Person auf der linken Seite (Scarlett Johansson) echt, während die Person auf der rechten Seite von der KI generiert wurde. Ihre Augäpfel sind unter ihren Gesichtern abgebildet. Die Reflexionen in den Augäpfeln sind bei der realen Person konsistent, bei der künstlichen Person jedoch (aus physikalischer Sicht) falsch. (Bildnachweis: Adejumoke Owolabi)

In der Astronomie können die CAS-Parameter die Struktur einer Galaxie bestimmen, indem sie die Konzentration, Asymmetrie und Glätte (oder „Klumpigkeit“) eines Lichtprofils untersuchen. Eine elliptische Galaxie zum Beispiel hat einen hohen C-Wert und niedrige A- und S-Werte – ihr Licht ist in ihrem Zentrum konzentriert, aber sie hat eine diffusere Hülle, was sie glatter und symmetrischer macht. Die beiden fanden jedoch heraus, dass CAS für die Erkennung von Deepfakes nicht so nützlich ist. Die Konzentration funktioniert am besten mit einem einzigen Lichtpunkt, aber Reflexionen erscheinen oft als Lichtflecken, die über einen Augapfel verstreut sind. Die Asymmetrie leidet unter einem ähnlichen Problem – diese Flecken machen die Reflexion asymmetrisch, und Pimbblet sagte, es sei schwierig, dieses Maß „richtig“ zu treffen.

Die Verwendung des Gini-Koeffizienten funktioniert viel besser. Mit diesem Koeffizienten lässt sich die Ungleichheit über ein ganzes Spektrum von Werten messen. Er kann verwendet werden, um eine Reihe von Ergebnissen im Zusammenhang mit Ungleichheit zu berechnen, z. B. die Verteilung von Vermögen, die Lebenserwartung oder – vielleicht am häufigsten – das Einkommen. In diesem Fall wurde Gini auf die Pixel-Ungleichheit angewandt.

„Gini nimmt die gesamte Pixelverteilung und ist in der Lage zu sehen, ob die Pixelwerte links und rechts ähnlich verteilt sind, und ist ein robuster nicht-parametrischer Ansatz für diesen Fall“, sagte Pimbblet.

Die Arbeit wurde am 15. Juli auf der Tagung der Royal Astronomical Society an der Universität von Hull vorgestellt, muss aber noch von Fachkollegen geprüft und veröffentlicht werden. Die beiden arbeiten daran, die Studie in eine Publikation zu verwandeln.

Pimbblet sagt, die Software sei in diesem Stadium lediglich ein Proof of Concept. Die Software zeigt immer noch falsch-positive und falsch-negative Ergebnisse an, mit einer Fehlerquote von etwa drei von zehn. Außerdem wurde sie bisher nur an einem einzigen KI-Modell getestet. „Wir haben sie nicht mit anderen Modellen getestet, aber das wäre ein naheliegender nächster Schritt“, sagt Pimbblet.

Dan Miller, Psychologe an der James Cook University in Australien, sagte, die Ergebnisse der Studie böten nützliche Informationen, warnte aber davor, dass sie für die Verbesserung der menschlichen Erkennung von Deepfakes nicht besonders relevant seien – zumindest noch nicht, da die Methode eine ausgefeilte mathematische Modellierung von Licht erfordere. Er merkte jedoch an, dass „die Ergebnisse die Entwicklung von Software zur Erkennung von Deepfakes unterstützen könnten“.

Und Software scheint notwendig zu sein, wenn man bedenkt, wie raffiniert die Fälschungen werden. In einer Studie aus dem Jahr 2023 untersuchte Miller, wie gut die Teilnehmer ein Deepfake-Video erkennen konnten, indem er einer Gruppe eine Liste mit visuellen Artefakten – wie Schatten oder Beleuchtung – gab, auf die sie achten sollten. Die Untersuchung ergab jedoch, dass diese Maßnahme überhaupt nicht funktionierte. Die Probanden konnten die Fälschungen nur so gut erkennen wie eine Kontrollgruppe, die keine Tipps erhalten hatte (was darauf hindeutet, dass mein persönliches Mini-Experiment oben ein Ausreißer sein könnte).

Der gesamte Bereich der KI scheint sich mit Lichtgeschwindigkeit zu bewegen, seit ChatGPT Ende 2022 veröffentlicht wurde. Pimbblet vermutet, dass der Ansatz des Paares auch mit anderen KI-Bildgeneratoren funktionieren würde, aber es ist auch wahrscheinlich, dass neuere Modelle in der Lage sein werden, „das physikalische Beleuchtungsproblem zu lösen“.

Diese Forschung wirft auch eine interessante Frage auf: Wenn KI in der Lage ist, Reflexionen zu erzeugen, die mit astronomischen Methoden bewertet werden können… könnte KI dann auch zur Erzeugung ganzer Galaxien verwendet werden?

Pimbblet sagt, dass es bereits Vorstöße in diesen Bereich gegeben hat. Er verweist auf eine Studie aus dem Jahr 2017, in der untersucht wurde, wie gut „generative adversarische Netzwerke“ oder GANs (die Technologie, die KI-Generatoren wie Midjourney oder ChatGPT zugrunde liegt) Galaxien aus degradierten Daten rekonstruieren können. Beobachtungsteleskope auf der Erde und im Weltraum können durch Rauschen und Hintergründe eingeschränkt werden, was zu Unschärfe und Qualitätsverlusten führt (selbst die beeindruckenden Bilder des James Webb Space Telescope müssen etwas bereinigt werden).

In der Studie von 2017 trainierten die Forscher ein großes KI-Modell auf Bildern von Galaxien und versuchten dann mit Hilfe des Modells, verschlechtertes Bildmaterial wiederherzustellen. Es war nicht immer perfekt – aber es war durchaus möglich, Merkmale der Galaxien aus minderwertigem Bildmaterial wiederherzustellen.

In einer Preprint-Studie aus dem Jahr 2019 wurden ebenfalls GANs verwendet, um ganze Galaxien zu simulieren.

Die Forscher weisen darauf hin, dass diese Arbeit angesichts der riesigen Datenmengen, die von den Missionen zur Beobachtung des Universums eingehen, sehr nützlich sein könnte. Es gibt keine Möglichkeit, all diese Daten zu sichten, so dass wir uns vielleicht an die KI wenden müssen. Die Generierung dieser Galaxien mit Hilfe von KI könnte dann wiederum KI darauf trainieren, in riesigen Datensätzen nach bestimmten Arten von Galaxien zu suchen. Das hört sich alles etwas dystopisch an, aber das ist es auch, wenn man unwirkliche Gesichter anhand subtiler Veränderungen der Reflexionen in ihren Augäpfeln erkennt.